كيف يعيد الذكاء الاصطناعي كتابة المهام اليومية لعلماء البيانات

من التخلص من المهام منخفضة القيمة إلى تسريع المشاريع عالية التأثير، إليك كيف يعيد الذكاء الاصطناعي تشكيل سير عمل علم البيانات

في مقالاتي السابقة، استكشفتُ وقارنت العديد من أدوات الذكاء الاصطناعي، على سبيل المثال، Data Science Agent من Google، و ChatGPT vs. Claude vs. Gemini لعلم البيانات و DeepSeek V3، وما إلى ذلك. ومع ذلك، هذه ليست سوى مجموعة فرعية صغيرة من جميع أدوات الذكاء الاصطناعي المتاحة لـ Data Science. على سبيل المثال لا الحصر، بعض الأدوات التي استخدمتها في العمل:

- OpenAI API: أستخدمه لتصنيف وتلخيص ملاحظات العملاء وتحديد نقاط الضعف في المنتج.

- ChatGPT و Gemini: يساعدانني في صياغة رسائل وأيميلات Slack، وكتابة تقارير التحليل، وحتى تقييمات الأداء.

- Glean AI: استخدمت Glean AI للعثور على إجابات بسرعة عبر الوثائق والاتصالات الداخلية.

- Cursor و Copilot: أستمتع بمجرد الضغط على tab-tab للإكمال التلقائي للتعليمات البرمجية والتعليقات.

- Hex Magic: أستخدم Hex لدفاتر البيانات التعاونية في العمل. كما أنها توفر ميزة تسمى Hex Magic لكتابة التعليمات البرمجية وإصلاح الأخطاء باستخدام الذكاء الاصطناعي التحادثي.

- Snowflake Cortex: يتيح Cortex AI للمستخدمين استدعاء نقاط نهاية Llm، وبناء RAG وخدمات تحويل النص إلى SQL باستخدام البيانات الموجودة في Snowflake.

أنا متأكد من أنه يمكنك إضافة المزيد إلى هذه القائمة، ويتم إطلاق أدوات ذكاء اصطناعي جديدة كل يوم. من المستحيل تقريبًا الحصول على قائمة كاملة في هذه المرحلة. لذلك، في هذه المقالة، أود أن أتراجع خطوة واحدة وأركز على سؤال أكبر: ما الذي نحتاجه حقًا كمحترفين في مجال البيانات، وكيف يمكن للذكاء الاصطناعي المساعدة؟

في القسم أدناه، سأركز على اتجاهين رئيسيين – التخلص من المهام منخفضة القيمة وتسريع العمل عالي القيمة.

1. التخلص من المهام منخفضة القيمة

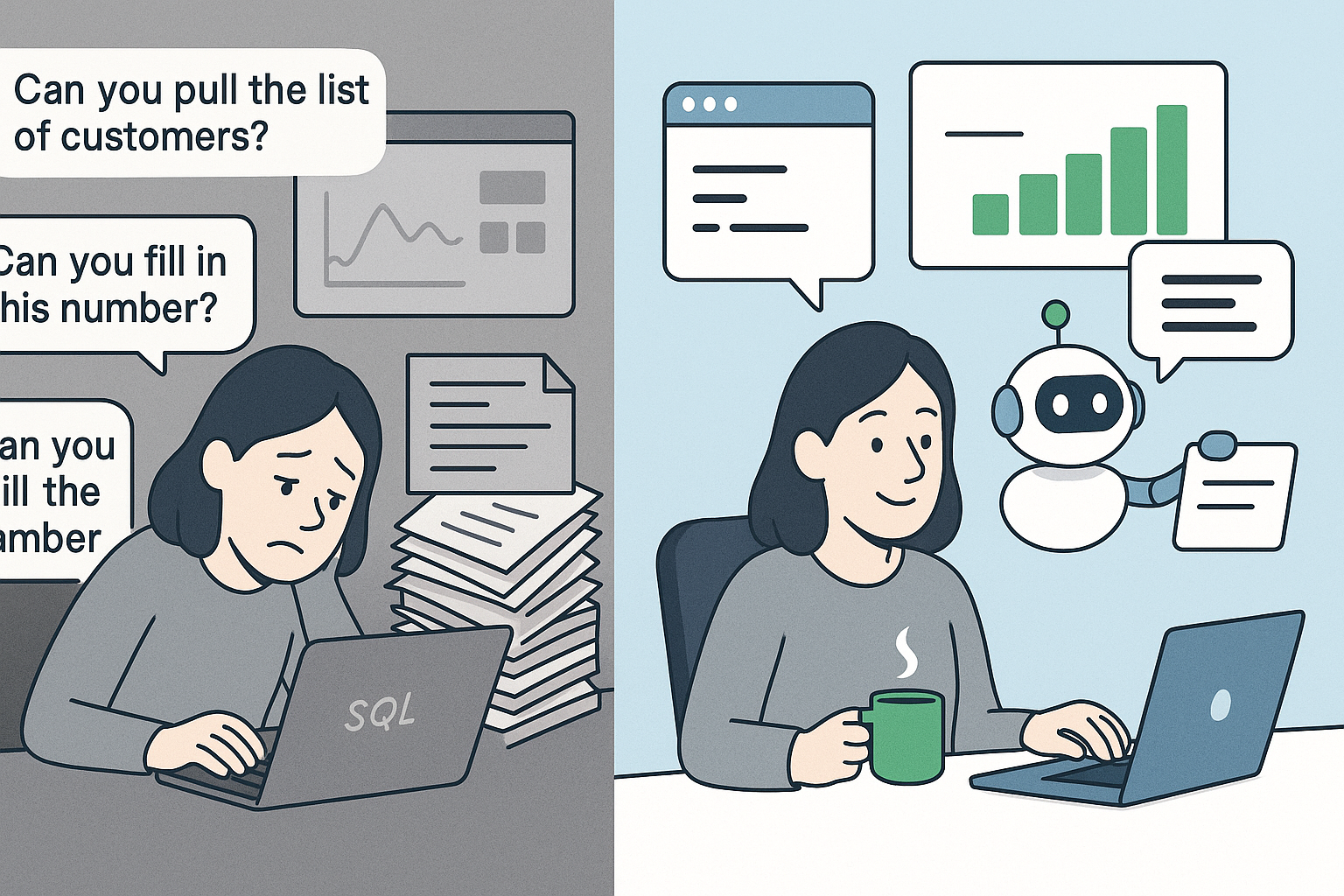

لقد أصبحت عالم بيانات لأنني أستمتع حقًا بالكشف عن رؤى الأعمال من البيانات المعقدة واتخاذ القرارات التجارية بناءً عليها. ومع ذلك، بعد أن عملت في هذا المجال لأكثر من 7 سنوات حتى الآن، يجب أن أعترف بأنه ليس كل العمل مثيرًا كما كنت آمل. قبل إجراء تحليلات متقدمة أو بناء نماذج تعلم الآلة، هناك العديد من تدفقات العمل منخفضة القيمة التي لا مفر منها يوميًا – وفي كثير من الحالات، يكون ذلك لأننا لا نمتلك الأدوات المناسبة لتمكين أصحاب المصلحة لدينا من التحليلات ذاتية الخدمة. دعونا نلقي نظرة على وضعنا اليوم والحالة المثالية:

الوضع الحالي: نحن نعمل كمفسرين للبيانات وحراس بوابة (في بعض الأحيان “قرود SQL”)

- طلبات سحب البيانات البسيطة تأتي إليّ وإلى فريقي على Slack كل أسبوع تسأل: “ما هو إجمالي قيمة البضائع (GMV) في الشهر الماضي؟” “هل يمكنك سحب قائمة العملاء الذين يستوفون هذه المعايير؟” “هل يمكنك مساعدتي في ملء هذا الرقم في العرض التقديمي الذي أحتاج إلى تقديمه غدًا؟”

- أدوات ذكاء الأعمال (BI) لا تدعم حالات الاستخدام ذاتية الخدمة بشكل جيد. لقد اعتمدنا أدوات ذكاء الأعمال مثل Looker و Tableau حتى يتمكن أصحاب المصلحة من استكشاف البيانات ومراقبة المقاييس بسهولة. ولكن الحقيقة هي أن هناك دائمًا مفاضلة بين البساطة والقدرة على الخدمة الذاتية. في بعض الأحيان، نجعل لوحات المعلومات سهلة الفهم مع عدد قليل من المقاييس، ولكنها لا يمكن أن تفي إلا بعدد قليل من حالات الاستخدام. وفي الوقت نفسه، إذا جعلنا الأداة قابلة للتخصيص بدرجة كبيرة مع القدرة على استكشاف المقاييس والبيانات الأساسية بحرية، فقد يجد أصحاب المصلحة الأداة مربكة ويفتقرون إلى الثقة لاستخدامها، وفي أسوأ الحالات، يتم سحب البيانات وتفسيرها بطريقة خاطئة.

- الوثائق قليلة أو قديمة. هذا وضع شائع، ولكن يمكن أن يكون سببه أسباب مختلفة – ربما نتحرك بسرعة ونركز على تقديم النتائج، أو لا توجد وثائق بيانات رائعة وسياسات حوكمة معمول بها. نتيجة لذلك، تصبح المعرفة القبلية هي عنق الزجاجة للأشخاص خارج فريق البيانات لاستخدام البيانات.

الحالة المثالية: تمكين أصحاب المصلحة من الخدمة الذاتية حتى نتمكن من تقليل العمل منخفض القيمة

- يمكن لأصحاب المصلحة إجراء عمليات سحب بيانات بسيطة والإجابة على أسئلة البيانات الأساسية بسهولة وثقة.

- يقضي فرق البيانات وقتًا أقل في إعداد التقارير المتكررة أو الاستعلامات الأساسية لمرة واحدة.

- لوحات المعلومات قابلة للاكتشاف وقابلة للتفسير وقابلة للتنفيذ دون مساعدة مباشرة.

إذًا، للاقتراب من الحالة المثالية، ما هو الدور الذي يمكن أن يلعبه الذكاء الاصطناعي هنا؟ مما لاحظته، هذه هي الاتجاهات الشائعة التي تتجه إليها أدوات الذكاء الاصطناعي لسد الفجوة:

- الاستعلام عن البيانات باللغة الطبيعية (Text-to-SQL): إحدى طرق خفض الحاجز التقني هي تمكين أصحاب المصلحة من الاستعلام عن البيانات باللغة الطبيعية. هناك الكثير من جهود Text-to-SQL في الصناعة:

- على سبيل المثال، Snowflake هي إحدى الشركات التي حققت الكثير من التقدم في نماذج Text2SQL وبدأت في دمج القدرة في منتجها.

- استكشفت العديد من الشركات (بما في ذلك شركتي) أيضًا حلول Text2SQL داخلية. على سبيل المثال، شاركت Uber رحلتها مع Uber’s QueryGPT لجعل الاستعلام عن البيانات أكثر سهولة لفريق العمليات الخاص بها. أوضحت هذه المقالة بالتفصيل كيف صممت Uber بنية متعددة الوكلاء لتوليد الاستعلامات. وفي الوقت نفسه، كشفت أيضًا عن تحديات كبيرة في هذا المجال، بما في ذلك تفسير نية المستخدم بدقة، والتعامل مع مخططات الجداول الكبيرة، وتجنب الهلوسة وما إلى ذلك.

- بصراحة، لجعل Text-to-SQL يعمل، هناك مستوى عالٍ جدًا حيث يجب عليك جعل الاستعلام دقيقًا – حتى إذا فشلت الأداة مرة واحدة فقط، فقد يؤدي ذلك إلى تدمير الثقة وفي النهاية سيعود أصحاب المصلحة إليك للتحقق من صحة الاستعلامات (ثم تحتاج إلى قراءة + إعادة كتابة الاستعلامات، مما يضاعف العمل تقريبًا 🙁). حتى الآن، لم أجد نموذجًا أو أداة Text-to-SQL تعمل بشكل مثالي. أرى أنه قابل للتحقيق فقط عندما تستعلم من مجموعة فرعية صغيرة جدًا من مجموعات البيانات الأساسية الموثقة جيدًا لحالات استخدام محددة وموحدة، ولكن من الصعب جدًا التوسع لتشمل جميع البيانات المتاحة وسيناريوهات الأعمال المختلفة.

- ولكن بالطبع، نظرًا للاستثمار الكبير في هذا المجال والتطور السريع في الذكاء الاصطناعي، أنا متأكد من أننا سنقترب أكثر فأكثر من حلول Text-to-SQL دقيقة وقابلة للتطوير.

- مساعد ذكاء الأعمال (BI) قائم على الدردشة: مجال شائع آخر لتحسين تجربة أصحاب المصلحة مع أدوات ذكاء الأعمال هو مساعد ذكاء الأعمال القائم على الدردشة. هذا في الواقع يأخذ خطوة أخرى إلى الأمام من Text-to-SQL – بدلاً من إنشاء استعلام SQL بناءً على مطالبة المستخدم، فإنه يستجيب بتنسيق تصور بالإضافة إلى ملخص نصي.

- Gemini in Looker هو مثال هنا. Looker مملوكة لـ Google، لذلك من الطبيعي جدًا بالنسبة لهم أن يتكاملوا مع Gemini. ميزة أخرى لـ Looker لبناء ميزة الذكاء الاصطناعي الخاصة بهم هي أن حقول البيانات موثقة بالفعل في طبقة LookML الدلالية، مع تحديد عمليات الربط الشائعة والمقاييس الشائعة المضمنة في لوحات المعلومات. لذلك، لديها الكثير من البيانات الرائعة للتعلم منها. يسمح Gemini للمستخدمين بضبط لوحات معلومات Looker وطرح أسئلة حول البيانات وحتى بناء وكلاء بيانات مخصصين للتحليلات الحوارية. على الرغم من أنه بناءً على تجربتي المحدودة مع الأداة، إلا أنها تنتهي في كثير من الأحيان بالفشل في الإجابة على الأسئلة البسيطة في بعض الأحيان. أخبرني إذا كانت لديك تجربة مختلفة وجعلتها تعمل…

- أطلقت Tableau أيضًا ميزة مماثلة، Tableau AI. لم أستخدمه بنفسي، ولكن بناءً على العرض التوضيحي، فإنه يساعد فريق البيانات على إعداد البيانات وإنشاء لوحات المعلومات بسرعة باستخدام اللغة الطبيعية، وتلخيص رؤى البيانات في “Tableau Pulse” لأصحاب المصلحة لتحديد تغييرات المقاييس والاتجاهات غير الطبيعية بسهولة.

- أدوات فهرسة البيانات: يمكن للذكاء الاصطناعي أيضًا المساعدة في التغلب على تحدي وثائق البيانات القليلة أو القديمة.

- خلال أحد هاكاثون داخلي، أتذكر أن أحد المشاريع من مهندسي البيانات لدينا كان استخدام LLM لزيادة تغطية وثائق الجدول. الذكاء الاصطناعي قادر على قراءة قاعدة التعليمات البرمجية ووصف الأعمدة وفقًا لذلك بدقة عالية في معظم الحالات، لذلك يمكن أن يساعد في تحسين الوثائق بسرعة مع التحقق من الصحة والتعديلات البشرية المحدودة.

- وبالمثل، عندما يقوم فريقي بإنشاء جداول جديدة، بدأنا في مطالبة Cursor بكتابة ملفات YAML الخاصة بوثائق الجدول لتوفير وقتنا بإنتاج عالي الجودة.

- هناك أيضًا الكثير من فهارس البيانات وأدوات الحوكمة التي تم دمجها مع الذكاء الاصطناعي. عندما أبحث في Google عن “فهرس بيانات الذكاء الاصطناعي”، أرى شعارات أدوات فهرسة البيانات مثل Atlan و Alation و Collibra و Informatica وما إلى ذلك (إخلاء المسؤولية: لم أستخدم أيًا منها..). هذا اتجاه صناعي واضح.

2. تسريع وتيرة العمل ذي القيمة العالية

بعد أن تحدثنا عن كيف يمكن للذكاء الاصطناعي أن يساعد في التخلص من المهام منخفضة القيمة، دعونا نناقش كيف يمكنه تسريع مشاريع البيانات ذات القيمة العالية. يشير “العمل ذو القيمة العالية” هنا إلى مشاريع البيانات التي تجمع بين التميز التقني والسياق التجاري، وتحقق تأثيرًا ذا مغزى من خلال التعاون متعدد الوظائف. على سبيل المثال، تحليل متعمق يفهم أنماط استخدام المنتج ويؤدي إلى تغييرات في المنتج، أو نموذج تنبؤ باحتمالية توقف العملاء عن التعامل بهدف تحديد العملاء المعرضين لخطر التوقف عن التعامل والنتائج في مبادرات منع التوقف عن التعامل. لنقارن بين الوضع الحالي والمستقبل المثالي:

الوضع الحالي: توجد اختناقات في الإنتاجية في سير العمل اليومي

- يستغرق التحليل الاستكشافي للبيانات (EDA) وقتًا طويلاً. هذه الخطوة ضرورية للحصول على فهم أولي للبيانات، ولكن قد يستغرق إجراء جميع التحليلات أحادية ومتعددة المتغيرات وقتًا طويلاً.

- الوقت الضائع في الترميز وتصحيح الأخطاء. لنكن صادقين – لا أحد يستطيع تذكر جميع تركيبات numpy و pandas ومعلمات نموذج sklearn. نحتاج باستمرار إلى البحث عن الوثائق أثناء الترميز.

- البيانات الغنية غير المنظمة لا يتم استغلالها بالكامل. تولد الأعمال الكثير من البيانات النصية كل يوم من الاستطلاعات وتذاكر الدعم والمراجعات. ولكن كيف يمكن استخلاص رؤى بشكل قابل للتطوير يظل تحديًا.

الحالة المثالية: يركز علماء البيانات على التفكير العميق، وليس على بناء الجملة

- كتابة التعليمات البرمجية تبدو أسرع دون الحاجة إلى البحث عن بناء الجملة.

- يقضي المحللون وقتًا أطول في تفسير النتائج، ووقتًا أقل في التعامل مع البيانات.

- لم تعد البيانات غير المنظمة عائقًا ويمكن تحليلها بسرعة.

عند رؤية الحالة المثالية، أنا متأكد من أن لديك بالفعل بعض أدوات الذكاء الاصطناعي في الاعتبار. دعونا نرى كيف يمكن للذكاء الاصطناعي أن يؤثر أو يحدث فرقًا بالفعل:

- مساعدو الذكاء الاصطناعي في الترميز وتصحيح الأخطاء. أعتقد أن هذا هو إلى حد بعيد النوع الأكثر اعتمادًا من أدوات الذكاء الاصطناعي لأي شخص يقوم بالترميز. ونحن نرى بالفعل تكراره.

- عندما ظهرت روبوتات الدردشة LLM مثل ChatGPT و Claude، أدرك المهندسون أنه يمكنهم ببساطة طرح أسئلة بناء الجملة أو رسائل الخطأ الخاصة بهم على روبوت الدردشة بإجابات عالية الدقة. لا يزال هذا يمثل انقطاعًا في سير عمل الترميز، ولكنه أفضل بكثير من النقر فوق عشرات علامات تبويب StackOverflow – وهذا يبدو بالفعل وكأنه القرن الماضي.

- في وقت لاحق، نرى المزيد والمزيد من أدوات ترميز الذكاء الاصطناعي المتكاملة تظهر – يتكامل GitHub Copilot و Cursor مع محرر التعليمات البرمجية الخاص بك ويمكنهما قراءة قاعدة التعليمات البرمجية الخاصة بك لاقتراح إكمال التعليمات البرمجية بشكل استباقي وتصحيح المشكلات داخل IDE الخاص بك.

- كما ذكرت بإيجاز في البداية، بدأت أدوات البيانات مثل Snowflake و Hex أيضًا في تضمين مساعدي ترميز الذكاء الاصطناعي لمساعدة محللي البيانات وعلماء البيانات على كتابة التعليمات البرمجية بسهولة.

- الذكاء الاصطناعي للتحليل الاستكشافي للبيانات والتحليل. هذا مشابه إلى حد ما لأدوات مساعد BI المستندة إلى الدردشة التي ذكرتها أعلاه، لكن هدفها أكثر طموحًا – فهي تبدأ بمجموعات البيانات الأولية وتهدف إلى أتمتة دورة التحليل بأكملها لتنظيف البيانات والمعالجة المسبقة والتحليل الاستكشافي وأحيانًا حتى النمذجة. هذه هي الأدوات التي يتم الإعلان عنها عادةً على أنها “تحل محل محللي البيانات” (ولكن هل هي كذلك؟).

- Google Data Science Agent هي أداة جديدة مثيرة للإعجاب للغاية يمكنها إنشاء دفتر Jupyter Notebook بالكامل بمطالبة بسيطة. كتبت مؤخرًا مقالاً يوضح ما يمكنه فعله وما لا يمكنه فعله. باختصار، يمكنه بسرعة إنشاء دفتر Jupyter Notebook منظم جيدًا ويعمل بناءً على خطة تنفيذ قابلة للتخصيص. ومع ذلك، فإنه يفتقر إلى القدرات اللازمة لتعديل دفتر Jupyter Notebook بناءً على أسئلة المتابعة، ولا يزال يتطلب شخصًا لديه معرفة قوية بعلوم البيانات لمراجعة الأساليب وإجراء التكرارات اليدوية، ويحتاج إلى بيان واضح لمشكلة البيانات مع مجموعات بيانات نظيفة وموثقة جيدًا. لذلك، أعتبره أداة رائعة لتوفير بعض الوقت في التعليمات البرمجية المبدئية، بدلاً من تهديد وظائفنا.

- يمكن أيضًا تصنيف أداة محلل البيانات في ChatGPT ضمن هذا المجال. يسمح للمستخدمين بتحميل مجموعة بيانات والدردشة معها لإنجاز تحليلهم وإنشاء تصورات والإجابة على الأسئلة. يمكنك العثور على مقالتي السابقة التي تناقش قدراتها هنا. كما أنه يواجه تحديات مماثلة ويعمل بشكل أفضل كمساعد EDA بدلاً من استبدال محللي البيانات.

- إمكانات البرمجة اللغوية العصبية سهلة الاستخدام وقابلة للتطوير. LLM رائع في المحادثات. لذلك، أصبحت البرمجة اللغوية العصبية أسهل بشكل كبير مع LLM اليوم.

- تستضيف شركتي هاكاثون داخليًا كل عام. أتذكر أن مشروع الهاكاثون الخاص بي قبل ثلاث سنوات كان محاولة BERT وطرق نمذجة الموضوعات التقليدية الأخرى لتحليل استجابات استطلاع NPS، والتي كانت ممتعة ولكن بصراحة كان من الصعب جدًا جعلها دقيقة وذات مغزى للأعمال. ثم قبل عامين، خلال الهاكاثون، جربنا OpenAI API لتصنيف وتلخيص بيانات الملاحظات نفسها – لقد عملت مثل السحر حيث يمكنك إجراء نمذجة موضوعية عالية الدقة وتحليل المشاعر وتصنيف الملاحظات كلها في مكالمة API واحدة فقط، وتناسب المخرجات جيدًا في سياق أعمالنا بناءً على مطالبة النظام. قمنا لاحقًا ببناء خط أنابيب داخلي تم توسيعه بسهولة ليشمل البيانات النصية عبر استجابات الاستطلاع وتذاكر الدعم ومكالمات المبيعات وملاحظات بحث المستخدم وما إلى ذلك، وأصبح مركز ملاحظات العملاء المركزي وأبلغ خريطة طريق منتجاتنا. يمكنك العثور على المزيد في هذه المدونة التقنية.

- هناك أيضًا الكثير من الشركات الجديدة التي تبني أدوات تحليل ملاحظات العملاء المدعومة بالذكاء الاصطناعي، وأدوات تحليل مراجعات المنتجات، وأدوات مساعد خدمة العملاء، وما إلى ذلك. الأفكار كلها متشابهة – الاستفادة من ميزة كيف يمكن لـ LLM فهم سياق النص وإجراء محادثات لإنشاء وكلاء متخصصين في الذكاء الاصطناعي في تحليل النصوص.

الخلاصة

من السهل الانشغال بملاحقة أحدث أدوات الذكاء الاصطناعي (AI). ولكن في نهاية المطاف، الأهم هو استخدام الذكاء الاصطناعي للتخلص مما يبطئنا وتسريع ما يدفعنا إلى الأمام. المفتاح هو البقاء عمليين: تبني ما ينجح اليوم، والبقاء فضوليين بشأن ما يظهر، وعدم إغفال الهدف الأساسي لعلم البيانات—وهو اتخاذ قرارات أفضل من خلال فهم أفضل.

التعليقات مغلقة.