Google تُطلق Gemini 2.0 Pro و Flash-Lite، وتربط نموذج التفكير Flash Thinking بيوتيوب والخرائط والبحث

بدأت سلسلة Gemini من نماذج اللغات الكبيرة (LLMs) من Google بداية صعبة منذ ما يقرب من عام مع بعض الحوادث المحرجة لـ توليد الصور بشكل خاطئ، لكنها تحسنت بشكل مطرد منذ ذلك الحين، ويبدو أن الشركة عازمة على جعل جهودها من الجيل الثاني – Gemini 2.0 – الأكبر والأفضل حتى الآن للمستهلكين والشركات.

اليوم، أعلنت الشركة عن الإصدار العام لـ Gemini 2.0 Flash، وقدمت Gemini 2.0 Flash-Lite، وطرحت نسخة تجريبية من Gemini 2.0 Pro.

هذه النماذج، المصممة لدعم المطورين والشركات، أصبحت الآن متاحة من خلال Google AI Studio و Vertex AI، مع توفر Flash-Lite في المعاينة العامة و Pro للاختبار المبكر.

كتب كوراي كافوكج أوغلو، المدير التقني لـ Google DeepMind، في منشور مدونة الشركة للإعلان: “ستتميز جميع هذه النماذج بإدخال متعدد الوسائط مع إخراج نصي عند الإصدار، مع توفر المزيد من الوسائط للاستخدام العام في الأشهر المقبلة” – مما يُظهر ميزة تقدمها Google على الطاولة حتى مع استمرار منافسين مثل DeepSeek و OpenAI في إطلاق منافسين أقوياء.

Google تُوظّف قدراتها متعددة الوسائط

لا يستطيع نموذج DeepSeek-R1 ولا نموذج o3-mini الجديد من OpenAI قبول المُدخلات متعددة الوسائط – أي الصور وتحميل الملفات أو المرفقات.

بينما يمكن لنموذج R1 قبولها على موقعه الإلكتروني وتطبيق الدردشة على الهاتف المحمول، إلا أنه يستخدم تقنية التعرف الضوئي على الأحرف (OCR)، وهي تقنية عمرها أكثر من 60 عامًا، لاستخراج النص فقط من هذه التحميلات – ولا يفهم أو يُحلل أيًا من الميزات الأخرى الموجودة فيها.

ومع ذلك، فإن كلاهما يُمثّل فئة جديدة من نماذج “التفكير” التي تستغرق وقتًا أطول عن عمد للتفكير في الإجابات والتأمل في “سلاسل الأفكار” وصحة ردودها. وهذا على عكس نماذج اللغات الكبيرة النموذجية مثل سلسلة Gemini 2.0 pro، لذا فإن المقارنة بين Gemini 2.0 و DeepSeek-R1 و OpenAI o3 أشبه بمقارنة التفاح بالبرتقال.

ولكن كانت هناك بعض الأخبار على صعيد التفكير من Google أيضًا اليوم: فقد أعلن سوندار بيتشاي، الرئيس التنفيذي لشركة Google، عبر منصة X عن تحديث تطبيق Google Gemini للهواتف المحمولة التي تعمل بنظامي iOS و Android من خلال نموذج التفكير المُنافس Gemini 2.0 Flash Thinking. يمكن ربط النموذج بتطبيقات Google Maps و YouTube و Google Search، مما يسمح بمجموعة جديدة كاملة من الأبحاث والتفاعلات التي تعمل بالذكاء الاصطناعي والتي لا يمكن لمنافسيها الجدد بدون هذه الخدمات مثل DeepSeek و OpenAI مُطابقتها.

لقد جربته لفترة وجيزة على تطبيق Google Gemini لنظام iOS على جهاز iPhone الخاص بي أثناء كتابة هذا المقال، وكان مثيرًا للإعجاب بناءً على استفساراتي الأولية، حيث فكّر في أوجه التشابه بين أفضل 10 مقاطع فيديو مشاهدة على YouTube في الشهر الماضي، كما قدم لي جدولًا بمكاتب الأطباء القريبة وساعات العمل/الإغلاق، كل ذلك في غضون ثوانٍ.

إطلاق الإصدار العام من Gemini 2.0 Flash

أصبح نموذج Gemini 2.0 Flash، الذي تم إطلاقه في البداية كإصدار تجريبي في ديسمبر، جاهزًا للإنتاج الآن.

تم تصميمه لتطبيقات الذكاء الاصطناعي عالية الكفاءة، ويوفر استجابات منخفضة زمن الوصول ويدعم التفكير متعدد الوسائط على نطاق واسع.

تكمن إحدى المزايا الرئيسية على المنافسة في نافذة السياق الخاصة به، أو عدد الرموز المميزة التي يمكن للمستخدم إضافتها في شكل مُحفز وتلقيها مرة أخرى في تفاعل واحد ذهابًا وإيابًا مع روبوت محادثة يعمل بتقنية LLM أو واجهة برمجة تطبيقات (API).

بينما تدعم العديد من النماذج الرائدة، مثل o3-mini الجديد من OpenAI الذي ظهر لأول مرة الأسبوع الماضي، 200000 رمز مميز أو أقل – أي ما يعادل رواية من 400 إلى 500 صفحة – يدعم Gemini 2.0 Flash مليون رمز مميز، مما يعني أنه قادر على التعامل مع كميات هائلة من المعلومات، مما يجعله مفيدًا بشكل خاص للمهام عالية التردد والواسعة النطاق.

Gemini 2.0 Flash-Lite: حلول الذكاء الاصطناعي بتكلفة منخفضة

يُعد Gemini 2.0 Flash-Lite نموذج لغة كبير جديد كليًا يهدف إلى توفير حلول ذكاء اصطناعي فعالة من حيث التكلفة دون المساومة على الجودة.

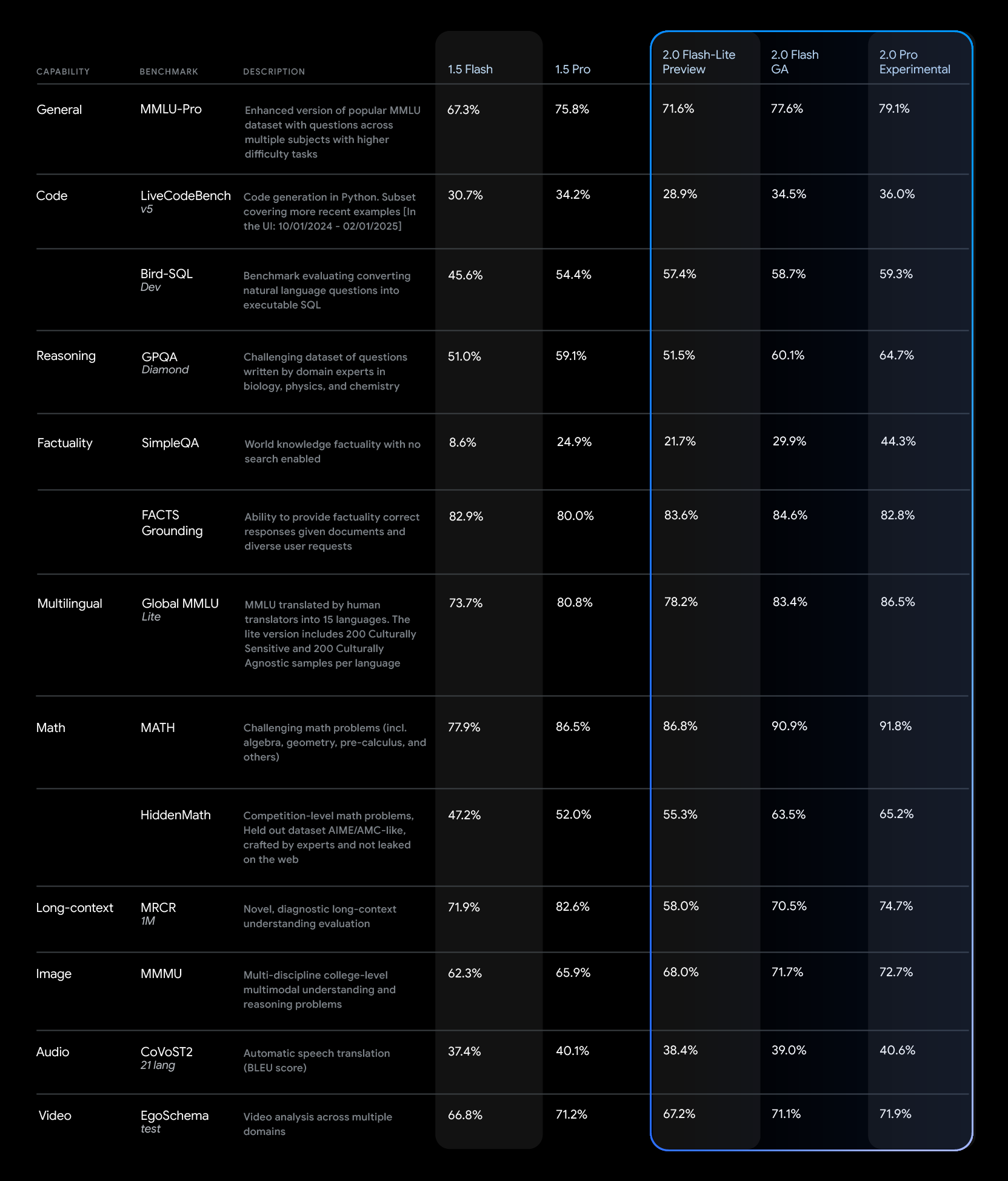

تُشير Google DeepMind إلى أن Flash-Lite يتفوق على الإصدار السابق ذي الحجم الكامل (عدد أكبر من المعلمات)، Gemini 1.5 Flash، في المعايير الخارجية مثل MMLU Pro (77.6٪ مقابل 67.3٪) وبرمجة Bird SQL (57.4٪ مقابل 45.6٪)، مع الحفاظ على نفس التسعير والسرعة.

كما أنه يدعم الإدخال متعدد الوسائط ويتميز بنافذة سياق تبلغ مليون رمز مميز، على غرار نموذج Flash الكامل.

يتوفر Flash-Lite حاليًا في معاينة عامة من خلال Google AI Studio و Vertex AI، مع توقع توفره بشكل عام في الأسابيع المقبلة.

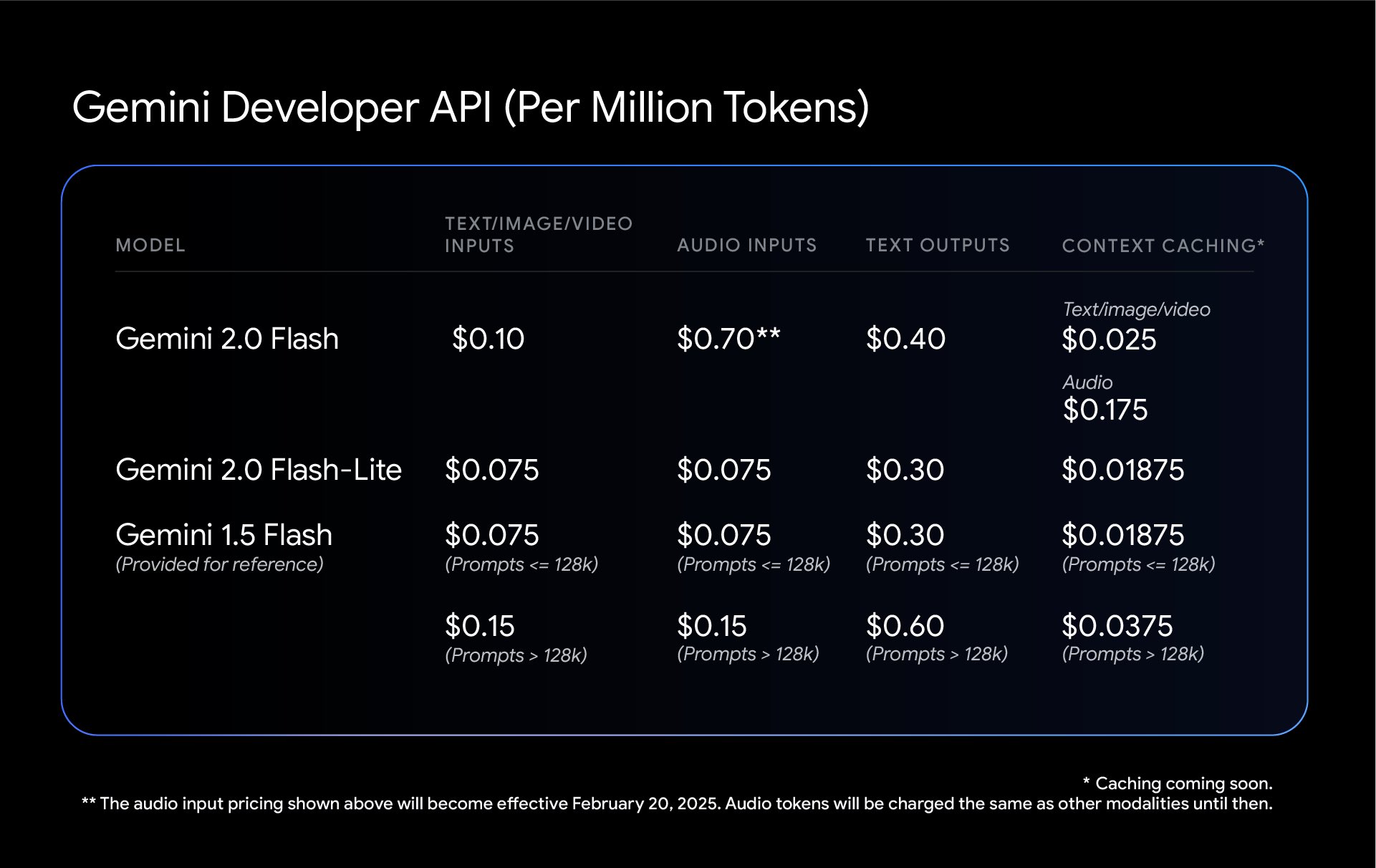

كما هو موضح في الجدول أدناه، يتم تسعير Gemini 2.0 Flash-Lite بسعر 0.075 دولار لكل مليون رمز مميز (إدخال) و 0.30 دولار لكل مليون رمز مميز (إخراج). يتميز Flash-Lite بأنه خيار ميسور التكلفة للغاية للمطورين، حيث يتفوق على Gemini 1.5 Flash في معظم المعايير مع الحفاظ على نفس هيكل التكلفة.

سلط لوجان كيلباتريك الضوء على تكلفة نماذج Gemini 2.0 Flash المناسبة وقيمتها، حيث ذكر على منصة X: “تُعد Gemini 2.0 Flash أفضل قيمة لأي نموذج LLM، لقد حان وقت البناء!”

في الواقع، بالمقارنة مع نماذج LLM التقليدية الرائدة الأخرى المتاحة من خلال واجهة برمجة تطبيقات المزود، مثل OpenAI 4o-mini (0.15 دولار / 0.6 دولار لكل مليون رمز مميز للإدخال / الإخراج)، و Anthropic Claude (0.8 دولار / 4 دولارات! لكل مليون رمز مميز للإدخال / الإخراج) وحتى DeepSeek’s traditional LLM V3 (0.14 دولار / 0.28 دولار)، يبدو أن Gemini 2.0 Flash هو الأفضل من حيث القيمة مقابل المال.

وصول Gemini 2.0 Pro بنسخته التجريبية مع نافذة سياق بسعة 2 مليون رمز

يتوفر الآن نموذج Gemini 2.0 Pro (التجريبي) للاختبار، وذلك للمستخدمين الذين يحتاجون إلى قدرات ذكاء اصطناعي أكثر تقدمًا.

تصف Google DeepMind هذا النموذج بأنه أقوى نماذجها لأداء البرمجة والقدرة على التعامل مع المطالبات المعقدة. يتميز بنافذة سياق بسعة 2 مليون رمز وقدرات تفكير محسّنة، مع إمكانية دمج أدوات خارجية مثل بحث Google وتنفيذ التعليمات البرمجية.

ناقش سام ويتيفين، المؤسس المشارك والرئيس التنفيذي لشركة Red Dragon AI وخبير تطوير التعلم الآلي الخارجي في Google والذي غالبًا ما يتعاون مع VentureBeat، النموذج الاحترافي في مراجعة على YouTube. “يحتوي نموذج Gemini 2.0 Pro الجديد على نافذة سياق بسعة مليوني رمز، ويدعم الأدوات، وتنفيذ التعليمات البرمجية، واستدعاء الدوال، والربط مع بحث Google – كل ما كان لدينا في الإصدار Pro 1.5، ولكن تم تحسينه.”

كما أشار إلى نهج Google التكراري في تطوير الذكاء الاصطناعي: “أحد الاختلافات الرئيسية في إستراتيجية Google هو أنها تُصدر إصدارات تجريبية من النماذج قبل أن تصبح متاحة بشكل عام (GA)، مما يسمح بالتكرار السريع بناءً على التعليقات”.

توضح معايير الأداء بشكل أكبر قدرات عائلة نماذج Gemini 2.0. على سبيل المثال، يتفوق Gemini 2.0 Pro على Flash و Flash-Lite في مهام مثل التفكير والفهم متعدد اللغات ومعالجة السياق الطويل.

![]() سلامة الذكاء الاصطناعي والتطورات المستقبلية

سلامة الذكاء الاصطناعي والتطورات المستقبلية

إلى جانب هذه التحديثات، تُطبق Google DeepMind إجراءات جديدة للسلامة والأمان لنماذج Gemini 2.0 الخاصة بها. وتستفيد الشركة من تقنيات التعلم المعزز لتحسين دقة الاستجابة، وذلك باستخدام الذكاء الاصطناعي لانتقاد مخرجاتها وتحسينها. بالإضافة إلى ذلك، يتم استخدام اختبار الأمان الآلي لتحديد نقاط الضعف، بما في ذلك تهديدات حقن المطالبات غير المباشرة.

وبالنظر إلى المستقبل، تُخطط Google DeepMind لتوسيع قدرات عائلة نماذج Gemini 2.0، مع توقع أن تصبح أساليب إضافية تتجاوز النص متاحة بشكل عام في الأشهر المقبلة.

مع هذه التحديثات، تُعزز Google توجهها نحو تطوير الذكاء الاصطناعي، حيث تُقدم مجموعة من النماذج المُصممة لتحقيق الكفاءة والقدرة على تحمل التكاليف وحل المشكلات المتقدمة، وتُجيب على صعود DeepSeek بمجموعتها الخاصة من النماذج التي تتراوح من القوية إلى القوية جدًا وبأسعار معقولة جدًا إلى أقل تكلفة قليلاً (ولكنها لا تزال معقولة).

هل سيكون ذلك كافيًا لمساعدة Google على اقتحام سوق الذكاء الاصطناعي للمؤسسات، والذي كان يهيمن عليه OpenAI في السابق وأصبح الآن تحت سيطرة DeepSeek؟ سنواصل المتابعة ونخبرك بذلك!

إذا كنت ترغب في إثارة إعجاب مديرك، فإن VB Daily ستساعدك. نُقدم لك المعلومات الداخلية حول ما تفعله الشركات باستخدام الذكاء الاصطناعي التوليدي، بدءًا من التحولات التنظيمية وصولاً إلى عمليات النشر العملية، بحيث يمكنك مشاركة الرؤى لتحقيق أقصى عائد على الاستثمار.

سلامة الذكاء الاصطناعي والتطورات المستقبلية

سلامة الذكاء الاصطناعي والتطورات المستقبلية

التعليقات مغلقة.