سماعات AI M2: ترجمة فورية لعدة مُتحدثين

لطالما قدمت سماعات الأذن اللاسلكية Pixel Buds من Google ميزة ترجمة فورية رائعة. على مدار السنوات القليلة الماضية، قدمت علامات تجارية مثل Timkettle سماعات أذن مماثلة لعملاء الأعمال. ومع ذلك، يمكن لجميع هذه الحلول التعامل مع دفق صوتي واحد فقط في المرة الواحدة للترجمة.

يشير الفريق إلى ابتكارهم باسم “Spatial Speech Translation” أو “ترجمة الكلام المكاني”، وهو يتحقق بفضل سماعات الرأس بكلتا الأذنين. بالنسبة لأولئك الذين ليسوا على دراية، تحاول تقنية الصوت بكلتا الأذنين محاكاة المؤثرات الصوتية تمامًا كما تسمعها الأذنين البشريتان بشكل طبيعي. لتسجيلها، يتم وضع الميكروفونات على رأس دمية، متباعدة على نفس المسافة التي تفصل بين الأذنين البشريتين على كل جانب. هذه التقنية تعتمد على تسجيل الصوت من مصدرين مختلفين لإنشاء تجربة استماع ثلاثية الأبعاد.

هذا النهج بالغ الأهمية لأن آذاننا لا تسمع الصوت فحسب، بل تساعدنا أيضًا في قياس اتجاه مصدره. الهدف الشامل هو إنتاج خشبة صوت طبيعية مع تأثير ستيريو يمكن أن يوفر إحساسًا حيويًا يشبه الحفلة الموسيقية. أو، في السياق الحديث، الاستماع المكاني. هذه التقنية تعزز تجربة المستخدم من خلال توفير صوت محيطي واقعي.

يأتي هذا العمل بفضل فريق بقيادة البروفيسور Shyam Gollakota، الذي يشتمل سجله الحافل على تطبيقات يمكنها وضع نظام تحديد المواقع العالمي (GPS) تحت الماء على الساعات الذكية، و تحويل الخنافس إلى مصورين، و غرسات دماغية يمكنها التفاعل مع الأجهزة الإلكترونية، و تطبيق جوال يمكنه سماع العدوى، والمزيد. هذه الإنجازات تبرز خبرة البروفيسور Gollakota في مجال التكنولوجيا المبتكرة.

كيفية عمل الترجمة متعددة المتحدثين؟

يوضح جولكوتا، الأستاذ الحالي في كلية Paul G. Allen لعلوم وهندسة الحاسب في المعهد: “لأول مرة، حافظنا على صوت كل شخص والاتجاه الذي يأتي منه”.

يشبه الفريق التقنية الخاصة بهم بالرادار، حيث تبدأ بالعمل عن طريق تحديد عدد المتحدثين في المناطق المحيطة، وتحديث هذا الرقم في الوقت الفعلي مع تحرك الأشخاص داخل وخارج نطاق الاستماع. يعتمد هذا النهج بالكامل على الجهاز ولا يتضمن إرسال تدفقات صوت المستخدم إلى خادم سحابي للترجمة. يا للخصوصية!

بالإضافة إلى ترجمة الكلام، تحافظ المجموعة أيضًا على “الصفات التعبيرية وحجم صوت كل متحدث”. علاوة على ذلك، يتم إجراء تعديلات اتجاهية وشدة الصوت مع تحرك المتحدث في جميع أنحاء الغرفة. ومن المثير للاهتمام، يُقال أيضًا أن Apple تقوم بتطوير نظام يسمح لـ AirPods بترجمة الصوت في الوقت الفعلي.

كيف تتحقق الترجمة الفورية بالذكاء الاصطناعي؟

قام فريق جامعة واشنطن (UW) باختبار قدرات الترجمة في سماعات الرأس الذكية التي تعمل بالذكاء الاصطناعي في ما يقرب من 12 موقعًا داخليًا وخارجيًا. من حيث الأداء، يمكن للنظام استقبال ومعالجة وإنتاج الصوت المترجم في غضون 2-4 ثوانٍ. يبدو أن المشاركين في الاختبار يفضلون تأخيرًا بقيمة 3-4 ثوانٍ، لكن الفريق يعمل على تسريع عملية الترجمة.

حتى الآن، اختبر الفريق ترجمات للغات الإسبانية والألمانية والفرنسية فقط، لكنهم يأملون في إضافة المزيد إلى المجموعة. من الناحية الفنية، قاموا بتكثيف فصل المصادر الأعمى، وتحديد الموقع، والترجمة التعبيرية في الوقت الفعلي، والتقديم بكلتا الأذنين في تدفق واحد، وهو إنجاز مثير للإعجاب للغاية. هذا التكامل للتقنيات المتطورة يمثل قفزة نوعية في مجال الترجمة الفورية.

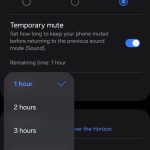

فيما يتعلق بالنظام، قام الفريق بتطوير نموذج ترجمة الكلام قادر على العمل في الوقت الفعلي على شريحة Apple M2، وتحقيق استدلال في الوقت الفعلي. تمت معالجة مهام الصوت بواسطة زوج من سماعات الرأس Sony WH-1000XM4 المانعة للضوضاء وميكروفون Sonic Presence SP15C ثنائي الأذنين USB.

وهنا الجزء الأفضل. يقول البيان الصحفي للمؤسسة: “إن كود الجهاز لإثبات صحة المفهوم متاح للآخرين للبناء عليه”. هذا يعني أن المجتمع العلمي والمجتمع المهتم بالبرامج مفتوحة المصدر يمكنهم التعلم والبناء على مشاريع أكثر تقدمًا استنادًا إلى الأسس التي وضعها فريق جامعة واشنطن. هذا يفتح الباب أمام تطويرات مستقبلية في تكنولوجيا الترجمة باستخدام الذكاء الاصطناعي.

Comments are closed.