كيفية تثبيت واستخدام Ollama لتشغيل نماذج لغوية كبيرة (LLMs) على الكمبيوتر بنظام Windows 11

هناك طرق متعددة لتشغيل نماذج لغوية كبيرة (LLMs) محليًا على جهازك الذي يعمل بنظام Windows، و Ollama هي إحدى أبسط هذه الطرق وأكثرها فعالية.

إن التفاعل الأكثر شيوعًا الذي يجريه معظمنا مع الذكاء الاصطناعي في الوقت الحالي يتم من خلال أدوات قائمة على السحابة مثل ChatGPT أو Copilot. تتطلب هذه الأدوات اتصالاً بالإنترنت لاستخدامها، ولكن المقابل لذلك هو أنها قابلة للاستخدام على أي جهاز تقريبًا.

ولكن ليس الجميع يريد الاعتماد على السحابة لاستخدامات الذكاء الاصطناعي، وخاصةً المطورين. لذلك، أنت تريد أن يتم تشغيل النموذج اللغوي الكبير (LLM) محليًا على جهازك. وهنا يأتي دور Ollama.

Ollama هي أداة استنتاج تسمح لك بتشغيل مجموعة واسعة من النماذج اللغوية الكبيرة (LLMs) أصليًا على الكمبيوتر الخاص بك. إنها ليست الطريقة الوحيدة التي يمكنك من خلالها تحقيق ذلك، ولكنها واحدة من أبسط الطرق وأكثرها مباشرة. Ollama يتيح لك الاستفادة من قوة الذكاء الاصطناعي دون الحاجة إلى اتصال دائم بالإنترنت، مما يوفر لك تحكمًا كاملاً في بياناتك وخصوصيتك.

بمجرد الإعداد والتشغيل، هناك الكثير الذي يمكنك القيام به باستخدام Ollama والنماذج اللغوية الكبيرة (LLMs) التي تستخدمها من خلاله، ولكن المرحلة الأولى هي الإعداد. لذلك دعنا نأخذك خلال هذه العملية خطوة بخطوة لتتمكن من الاستفادة القصوى من هذه الأداة القوية.

متطلبات تشغيل Ollama

تشغيل Ollama نفسه لا يستهلك الكثير من موارد النظام ويمكن القيام به على نطاق واسع من الأجهزة. فهو متوافق مع Windows 11 و macOS و Linux. يمكنك حتى استخدامه من خلال توزيعات Linux الخاصة بك داخل Windows 11 عبر WSL.

لكن الأمر الذي يتطلب أجهزة أقوى هو تشغيل نماذج اللغات الكبيرة (LLMs) نفسها. فكلما كان النموذج أكبر، كلما احتجت إلى قوة معالجة أكبر. تحتاج هذه النماذج إلى وحدة معالجة رسوميات (GPU) لتشغيلها. في الوقت الحالي، لم يتم تحسينها للعمل على وحدة المعالجة العصبية (NPU) في أجهزة Copilot+ PC الجديدة.

لحسن الحظ، هناك نماذج صغيرة يمكنك استخدامها على أجهزة متواضعة. على سبيل المثال، نموذج Gemma 3 من Google لديه نموذج بـ 1 مليار معلمة يتطلب فقط 2.3GB من ذاكرة الوصول العشوائي المرئي (VRAM) لتشغيل النموذج الكامل. يرتفع هذا الرقم إلى أكثر من 9GB من VRAM إذا انتقلت إلى نموذج الـ 4 مليارات معلمة.

الأمر مشابه مع Llama 3.2 من Meta، حيث يتطلب نموذج الـ 1 مليار معلمة وحدة معالجة رسوميات (GPU) بذاكرة 4GB VRAM فقط لتشغيله بنجاح. ثم يرتفع هذا إلى 8GB لنموذج الـ 3 مليارات معلمة.

باختصار، إذا كان لديك جهاز كمبيوتر حديث نسبيًا بذاكرة وصول عشوائي (RAM) لا تقل عن 8GB ووحدة معالجة رسوميات (GPU) مخصصة، فيجب أن تكون قادرًا على تحقيق بعض الاستفادة باستخدام Ollama.

دليل تثبيت Ollama على Windows 11

تثبيت برنامج Ollama على Windows 11 عملية سهلة للغاية، وتتلخص في تنزيل مثبت البرنامج من الموقع الرسمي أو من مستودع GitHub، ثم تثبيته على جهازك.

هذه هي الخطوات ببساطة.

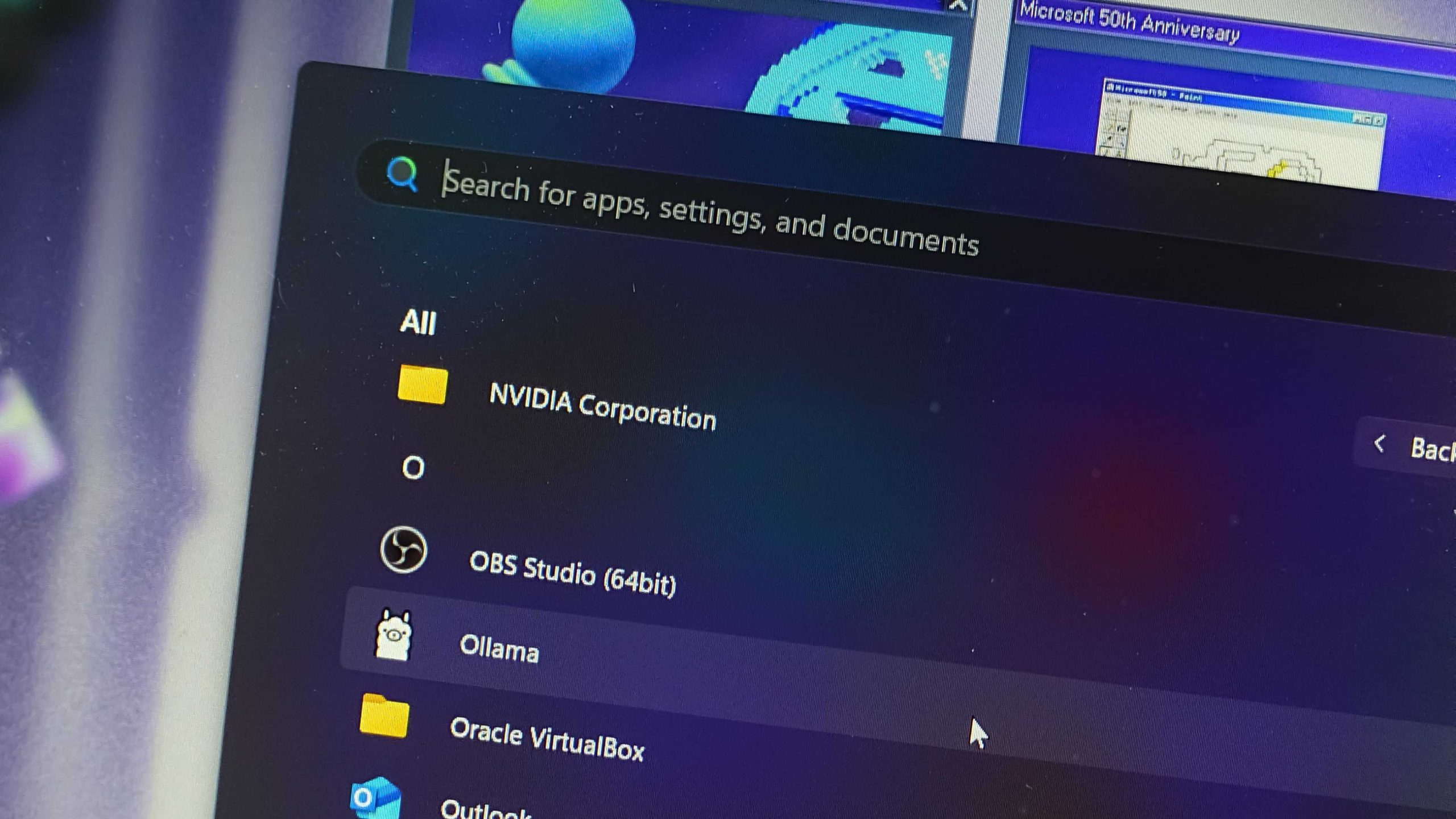

بعد التثبيت والتشغيل، لن يظهر أي شيء على سطح المكتب الخاص بك. يعمل البرنامج بالكامل في الخلفية، ولكن يمكنك رؤية الأيقونة الخاصة به في شريط المهام.

للتحقق من أن البرنامج يعمل بشكل صحيح، يمكنك الانتقال إلى العنوان localhost:11434 في متصفح الويب الخاص بك.

تثبيت وتشغيل أول نموذج لغوي كبير (LLM) على Ollama

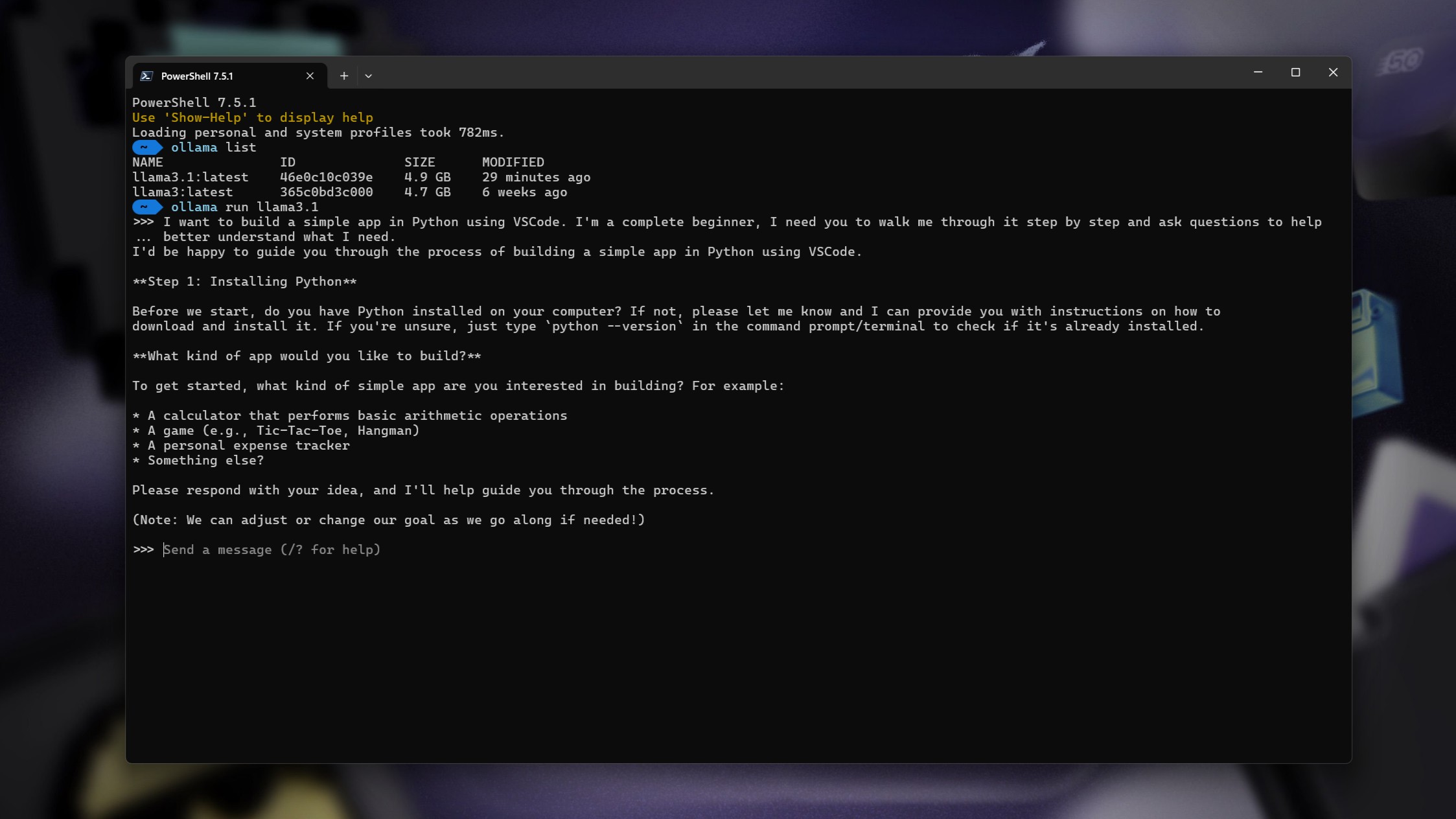

لتشغيل أول نموذج لغوي كبير (LLM) باستخدام Ollama، ستحتاج إلى استخدام واجهة سطر الأوامر (CLI) بشكل أساسي. افتح تطبيق PowerShell على Windows، أو استخدم WSL إذا قمت بتثبيت Ollama هناك.

على الرغم من وجود واجهات مستخدم رسومية (GUI) لـ Ollama، فإننا نركز هنا على استخدام سطر الأوامر. من المفيد أن تكون مرتاحًا لاستخدام CLI.

الأمران الرئيسيان اللذان تحتاج إلى معرفتهما هما:

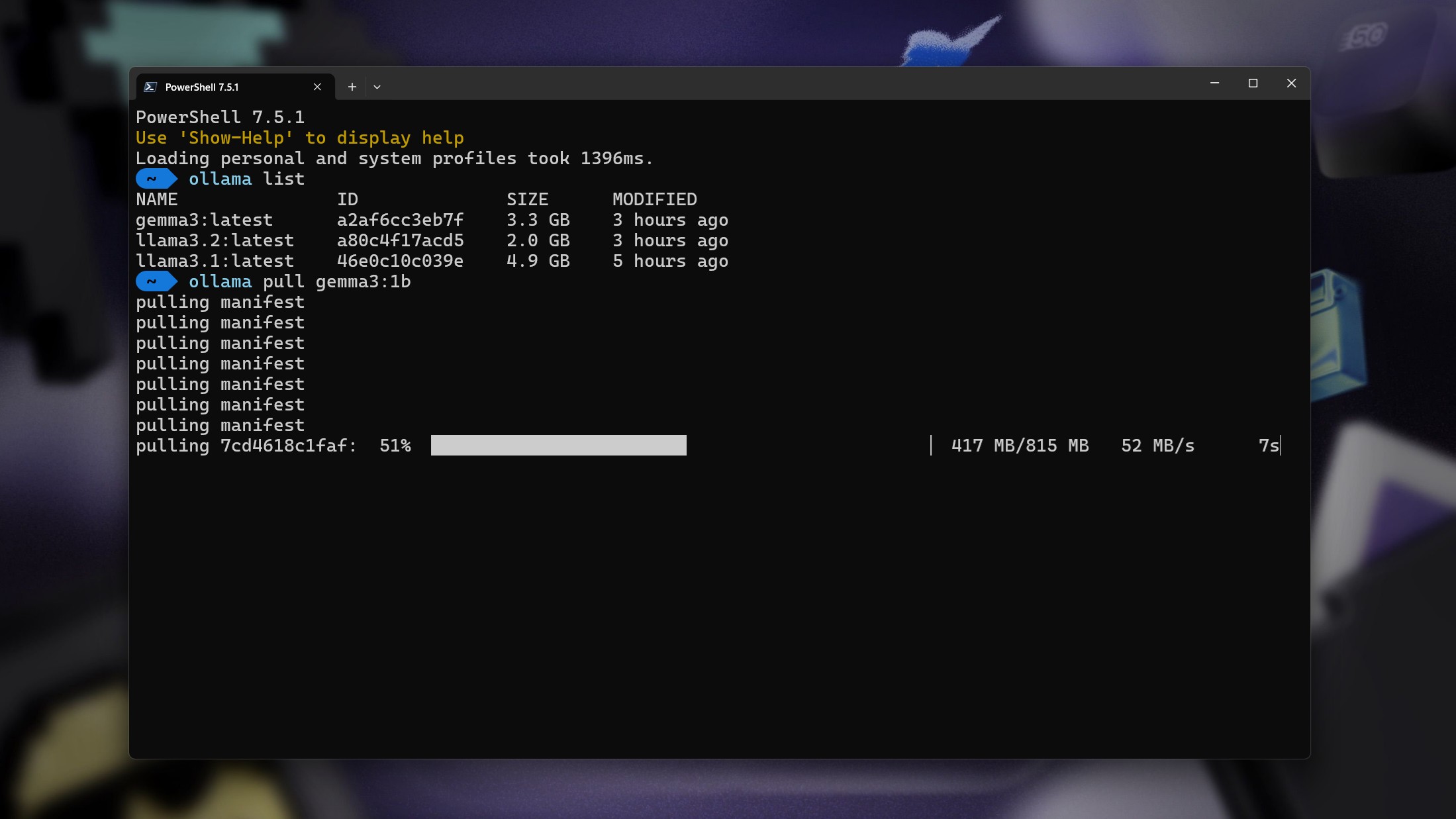

ollama run

ollama put

إذا طلبت من Ollama تشغيل نموذج LLM غير مثبت حاليًا، فسوف يقوم تلقائيًا بتنزيله أولاً ثم تشغيله. يمكنك العثور على الأسماء الصحيحة للنماذج اللغوية الكبيرة التي تريد تثبيتها بسهولة على موقع Ollama الإلكتروني.

على سبيل المثال، لتثبيت وتشغيل نموذج Google Gemma 3 LLM ذي الـ 1 مليار معلمة، أدخل الأمر التالي:

ollama run Gemma:1b

لاحظ أن إضافة :1b بعد الاسم تحدد أنك تريد النموذج ذي الـ 1 مليار معلمة. إذا كنت تريد النموذج ذي الـ 4 مليارات معلمة، فستغيره إلى **:4b**.

سيؤدي تشغيل النماذج في جهازك الطرفي إلى فتح تجربة chatbot مألوفة، مما يتيح لك كتابة مطالباتك وتلقي ردودك، وكل ذلك يتم تشغيله محليًا على جهازك.

للخروج من النموذج والعودة إلى PowerShell، ما عليك سوى كتابة **/bye** وسيتم إنهاء العملية.

يغطي هذا الأساسيات المطلقة لإعداد Ollama على الكمبيوتر الخاص بك لاستخدام مجموعة LLMs المتاحة له. التجربة الأساسية بسيطة للغاية وسهلة الاستخدام، ولا تتطلب أي معرفة تقنية تقريبًا لإعدادها. إذا استطعت فعل ذلك، يمكنك أنت أيضًا!

Comments are closed.