مخاطر الذكاء الاصطناعي المُؤسسي: بدائل OpenAI والمؤسسات الكامنة وراء وكلاء الذكاء الاصطناعي

خصوصية البيانات والامتثال وفجوات الثقة في عمليات تكامل وكلاء الذكاء الاصطناعي الحالية

“انتظر… هل ترسل إدخالات دفتر المُحاسبات إلى OpenAI؟”

كان هذا أول شيء سألته صديقتي عندما عرضت عليها Feel-Write، وهو تطبيق تدوين يوميات مدعوم بالذكاء الاصطناعي قمت ببنائه خلال هاكاثون في سان فرانسيسكو.

هزت كتفي.

“كان هاكاثون تحت عنوان الذكاء الاصطناعي، وكان علي بناء شيء ما بسرعة.”

لم تفوتها لحظة:

“بالتأكيد. ولكن كيف أثق بما بنيته؟ لماذا لا تستضيف نموذج اللغة الكبير LLM الخاص بك بنفسك؟”

أوقفني ذلك.

كنت فخوراً بالسرعة التي تم بها تجميع التطبيق. لكن هذا السؤال الواحد، والأسئلة التي تلته كشفت كل ما كنت أعتقد أنني أعرفه عن البناء بمسؤولية باستخدام الذكاء الاصطناعي. أشار إليه حكام الهاكاثون أيضاً.

جعلتني تلك اللحظة أدرك مدى استهتارنا بالثقة عند البناء باستخدام الذكاء الاصطناعي، خاصة مع الأدوات التي تتعامل مع البيانات الحساسة.

أدركت شيئاً أكبر:

نحن لا نتحدث بما فيه الكفاية عن الثقة عند البناء باستخدام الذكاء الاصطناعي.

بقيت إجابتها عالقة في ذهني. جورجيا فون ميندن هي عالمة بيانات في ACLU، حيث تعمل عن كثب مع قضايا تتعلق بمعلومات التعريف الشخصية في السياقات القانونية والحقوق المدنية. لطالما قدرت رؤيتها، لكن هذه المحادثة كانت مختلفة.

لذلك طلبت منها أن تشرح المزيد ماذا تعني الثقة حقاً في هذا السياق؟ خاصة عندما تتعامل أنظمة الذكاء الاصطناعي مع البيانات الشخصية.

قالت لي:

“إن الثقة قد تكون صعبة التحديد، ولكن حوكمة البيانات هي نقطة بداية جيدة. من يملك البيانات، وكيف يتم تخزينها، وما هي استخداماتها، كلها أمور مهمة. قبل 10 سنوات، كنت سأجيب على هذا السؤال بشكل مختلف. ولكن اليوم، مع القدرة الحاسوبية الهائلة ومخازن البيانات الضخمة، أصبح الاستنتاج واسع النطاق مصدر قلق حقيقي. تمتلك OpenAI وصولاً كبيراً إلى كل من الحوسبة والبيانات، وعدم شفافيتها يجعل الحذر أمراً منطقياً.”

“عندما يتعلق الأمر بالمعلومات الشخصية التعريفية (PII)، تشير كل من اللوائح والحس السليم إلى الحاجة إلى حوكمة بيانات قوية. إن إرسال المعلومات الشخصية التعريفية في استدعاءات واجهة برمجة التطبيقات (API) ليس مجرد أمر محفوف بالمخاطر – بل قد ينتهك أيضاً هذه القواعد ويعرض الأفراد للأذى.”

لقد ذكرني ذلك بأنه عندما نبني باستخدام الذكاء الاصطناعي، وخاصة الأنظمة التي تتعامل مع بيانات حساسة للبشر، فإننا لا نكتب مجرد تعليمات برمجية.

نحن نتخذ قرارات بشأن الخصوصية، والسلطة، والثقة.

في اللحظة التي تجمع فيها بيانات المستخدم، وخاصةً شيئًا شخصيًا مثل مدخلات دفتر اليومية، فإنك تخطو إلى مساحة من المسؤولية. لا يتعلق الأمر فقط بما يمكن أن يفعله نموذجك. بل يتعلق بما يحدث لتلك البيانات، وإلى أين تذهب، ومن يمكنه الوصول إليها. إن إدارة بيانات المستخدم بمسؤولية تزيد من ثقة المستخدم وتعزز الخصوصية.

وهم البساطة

أصبح اليوم من السهل أكثر من أي وقت مضى إطلاق شيء يبدو ذكيًا. فبوجود نماذج اللغات الكبيرة (LLMs) مثل OpenAI وغيرها، يمكن للمطورين بناء أدوات الذكاء الاصطناعي في غضون ساعات. ويمكن للشركات الناشئة إطلاق ميزات “مدعومة بالذكاء الاصطناعي” بين عشية وضحاها. أما المؤسسات؟ فهي تسرع لدمج هذه الوكلاء في سير عملها.

ولكن في كل هذا الحماس، غالبًا ما يتم تجاهل شيء واحد: الثقة.

عندما يتحدث الناس عن وكلاء الذكاء الاصطناعي (AI Agents)، فإنهم غالبًا ما يشيرون إلى أغلفة بسيطة حول نماذج اللغات الكبيرة (LLMs). قد يجيب هؤلاء الوكلاء على الأسئلة، أو يقومون بأتمتة المهام، أو حتى اتخاذ القرارات. ولكن يتم بناء العديد منها على عجل، مع إيلاء القليل من الاهتمام للأمن أو الامتثال أو المساءلة.

مجرد استخدام منتج لـ OpenAI لا يعني أنه آمن. ما تثق به حقًا هو خط الأنابيب بأكمله:

- من قام ببناء الغلاف؟

- كيف يتم التعامل مع بياناتك؟

- هل يتم تخزين معلوماتك أو تسجيلها – أو الأسوأ من ذلك، تسريبها؟

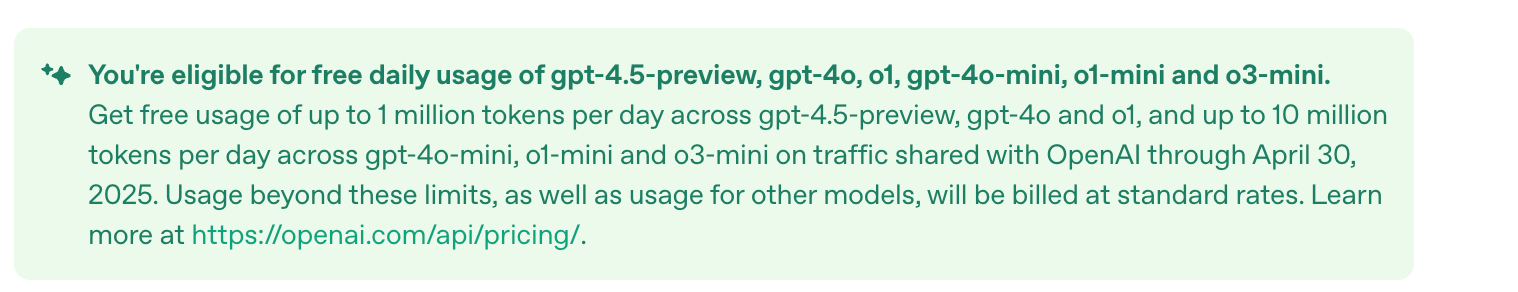

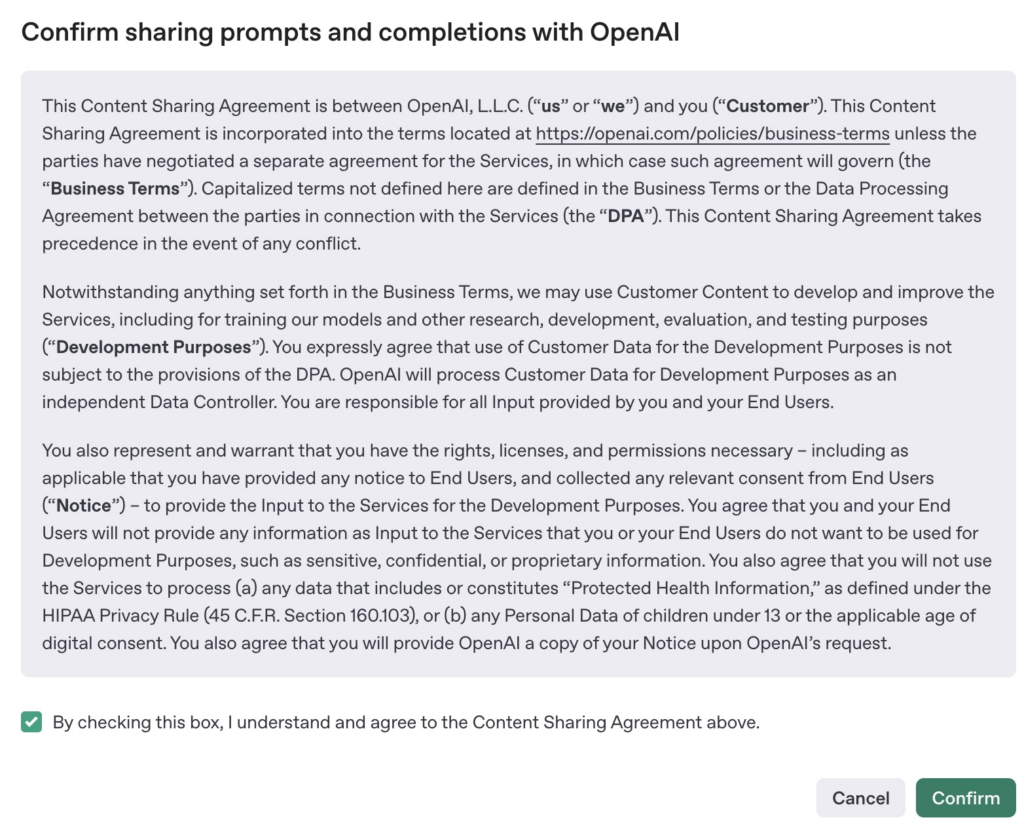

لقد كنت أستخدم واجهة برمجة التطبيقات (API) الخاصة بـ OpenAI لحالات استخدام العملاء بنفسي. مؤخرًا، عُرض عليّ الوصول المجاني إلى واجهة برمجة التطبيقات (API) – ما يصل إلى 1 مليون رمز يوميًا حتى نهاية شهر أبريل – إذا وافقت على مشاركة بيانات المطالبات الخاصة بي.

كادت أن أوافق على ذلك لمشروع شخصي جانبي، ولكن بعد ذلك خطر لي: إذا قبل مزود حلول نفس الصفقة لخفض التكاليف، فلن يكون لدى مستخدميه أي فكرة عن مشاركة بياناتهم. على المستوى الشخصي، قد يبدو ذلك غير ضار. ولكن في سياق المؤسسة؟ هذا انتهاك خطير للخصوصية، وربما للالتزامات التعاقدية أو التنظيمية.

كل ما يتطلبه الأمر هو أن يقول مهندس واحد “نعم” لصفقة كهذه، وستكون بيانات عملائك في أيدي شخص آخر.

الذكاء الاصطناعي المؤسسي يرفع سقف التوقعات

أرى المزيد من شركات SaaS والشركات الناشئة في مجال أدوات التطوير تجرب استخدام وكلاء الذكاء الاصطناعي. البعض يحقق نتائج جيدة، حيث تتيح بعض وكلاء الذكاء الاصطناعي للمستخدمين إحضار نماذج اللغة الكبيرة الخاصة بهم (LLM)، مما يمنحهم التحكم في مكان تشغيل النموذج وكيفية معالجة البيانات. هذا توجه حكيم، خاصة مع تزايد أهمية الذكاء الاصطناعي في المؤسسات.

هذا هو النهج المدروس: أنت تحدد حدود الثقة.

لكن ليس الجميع حريصًا جدًا.

العديد من الشركات ببساطة تقوم بالاتصال بـ API الخاص بـ OpenAI، وتضيف بعض الأزرار، وتطلق عليه “جاهز للمؤسسات”.

تنبيه: هذا ليس صحيحًا.

ما الذي يمكن أن يسوء؟ الكثير.

إذا كنت تقوم بدمج وكلاء الذكاء الاصطناعي في بنيتك التحتية دون طرح الأسئلة الصعبة، فإليك المخاطر المحتملة:

- تسرب البيانات: قد تتضمن مطالباتك بيانات حساسة للعملاء، أو مفاتيح واجهة برمجة التطبيقات (API keys)، أو منطقًا داخليًا – وإذا تم إرسال ذلك إلى نموذج طرف ثالث، فقد يتم كشفه.

في عام 2023، قام مهندسو Samsung عن غير قصد بلصق التعليمات البرمجية المصدر الداخلية والملاحظات في ChatGPT (Forbes). يمكن أن تكون هذه البيانات الآن جزءًا من مجموعات التدريب المستقبلية – وهو خطر كبير على الملكية الفكرية.

- انتهاكات الامتثال: يمكن أن يؤدي إرسال معلومات التعريف الشخصية (PII) من خلال نموذج مثل OpenAI بدون ضوابط مناسبة إلى انتهاك اللائحة العامة لحماية البيانات (GDPR) أو قانون HIPAA أو العقود الخاصة بك.

تعلمت شركة X التابعة لـ Elon Musk ذلك بالطريقة الصعبة. أطلقوا روبوت الدردشة الخاص بهم بالذكاء الاصطناعي “Grok” باستخدام جميع منشورات المستخدمين بما في ذلك من مستخدمي الاتحاد الأوروبي لتدريبه، دون الاشتراك المناسب. تدخل المنظمون بسرعة. وتحت الضغط، أوقفوا تدريب Grok في الاتحاد الأوروبي (Politico).

- سلوك مبهم: يصعب تصحيح أو شرح الوكلاء غير الحتميين. ماذا يحدث عندما يسأل أحد العملاء عن سبب تقديم روبوت الدردشة لتوصية خاطئة أو كشف شيء سري؟ أنت بحاجة إلى الشفافية للإجابة على ذلك – والعديد من الوكلاء اليوم لا يقدمونها.

- التباس حول ملكية البيانات: من يملك الناتج؟ من يسجل البيانات؟ هل يعيد مزود الخدمة التدريب على مدخلاتك؟

تم القبض على Zoom وهي تفعل ذلك بالضبط في عام 2023. لقد قاموا بتغيير شروط الخدمة الخاصة بهم بهدوء للسماح باستخدام بيانات اجتماع العملاء لتدريب الذكاء الاصطناعي (Fast Company). بعد رد فعل عنيف من الجمهور، قاموا بعكس السياسة ولكن كان ذلك بمثابة تذكير بأنه يمكن فقدان الثقة بين عشية وضحاها.

- إغفالات أمنية في الأغلفة: في عام 2024، تم العثور على العشرات من عمليات نشر Flowise – وهي أداة شائعة لتنسيق LLM منخفضة التعليمات البرمجية – معرضة للإنترنت، والعديد منها بدون مصادقة (Cybersecurity News). اكتشف الباحثون مفاتيح واجهة برمجة التطبيقات (API keys) وبيانات اعتماد قاعدة البيانات وبيانات المستخدمين في العراء. هذه ليست مشكلة OpenAI – هذه مشكلة بُناة. لكن المستخدمين النهائيين ما زالوا يدفعون الثمن.

- ميزات الذكاء الاصطناعي التي تذهب بعيدًا جدًا: التقطت ميزة “Recall” من Microsoft – وهي جزء من طرح Copilot الخاص بهم – لقطات شاشة تلقائية لنشاط المستخدمين لمساعدة مساعد الذكاء الاصطناعي في الإجابة على الأسئلة (DoublePulsar). بدا الأمر مفيدًا… حتى أشار متخصصو الأمن إليه على أنه كابوس للخصوصية. اضطرت Microsoft إلى التراجع بسرعة وجعل الميزة اختيارية فقط.

ليس كل شيء يحتاج إلى OpenAI

OpenAI منصة قوية بشكل لا يصدق. ولكنها ليست دائمًا الحل الأمثل.

في بعض الأحيان، يكون نموذج محلي أصغر كافيًا تمامًا. وأحيانًا أخرى، يقوم المنطق القائم على القواعد بالمهمة بشكل أفضل. وغالبًا ما يكون الخيار الأكثر أمانًا هو الخيار الذي يعمل بالكامل داخل البنية التحتية الخاصة بك، وفقًا لقواعدك.

لا ينبغي لنا أن نقوم بتوصيل نموذج لغوي كبير (LLM) بشكل أعمى ونطلق عليه اسم “مساعد ذكي”.

في المؤسسات، الثقة والشفافية والتحكم ليست خيارات إضافية – بل هي أساسية.

هناك عدد متزايد من المنصات التي تتيح هذا النوع من التحكم. يدعم Einstein 1 Studio من Salesforce الآن ميزة إحضار النموذج الخاص بك (bring-your-own-model)، مما يتيح لك توصيل النموذج اللغوي الكبير (LLM) الخاص بك من AWS أو Azure. يتيح Watson من IBM للمؤسسات نشر النماذج داخليًا مع مسارات تدقيق كاملة. تتيح لك Databricks، مع MosaicML، تدريب نماذج لغوية كبيرة (LLM) خاصة داخل السحابة الخاصة بك، بحيث لا تترك بياناتك الحساسة البنية التحتية الخاصة بك أبدًا.

هذا ما يجب أن تبدو عليه الذكاء الاصطناعي الحقيقي للمؤسسات.

الخلاصة

تتميز وكلاء الذكاء الاصطناعي بقوتها الكبيرة، حيث تتيح إمكانية إطلاق سير العمل والأتمتة التي لم نتمكن من تحقيقها من قبل. ومع ذلك، فإن سهولة التطوير لا تعني بالضرورة أنها آمنة، خاصة عند التعامل مع البيانات الحساسة على نطاق واسع.

قبل البدء في استخدام هذا الوكيل الجديد اللامع، اسأل نفسك:

- من يتحكم في النموذج؟

- إلى أين تذهب البيانات؟

- هل نحن ملتزمون باللوائح؟

- هل يمكننا تدقيق ما يفعله؟

في عصر الذكاء الاصطناعي، الخطر الأكبر ليس التكنولوجيا السيئة، بل الثقة العمياء.

نبذة عن الكاتبة

أنا إيلين، مهندسة تعلم آلي بخبرة 6 سنوات، أعمل حاليًا في شركة ناشئة في مجال التكنولوجيا المالية في سان فرانسيسكو. يمتد خلفيتي إلى أدوار علم البيانات في مجال استشارات النفط والغاز، بالإضافة إلى قيادة برامج التدريب على الذكاء الاصطناعي والبيانات في جميع أنحاء منطقة آسيا والمحيط الهادئ والشرق الأوسط وأوروبا.

أكمل حاليًا درجة الماجستير في علم البيانات (أتخرج في مايو 2025) وأبحث بنشاط عن فرصتي التالية كمهندسة تعلم آلي. إذا كنت منفتحًا على الإحالة أو التواصل، فسأكون ممتنًا حقًا!

أحب إحداث تأثير حقيقي في العالم من خلال الذكاء الاصطناعي وأنا منفتحة دائمًا على التعاون القائم على المشاريع أيضًا.

التعليقات مغلقة.